是一种基于策略梯度的强化学习方法

是TRPO的一个改进的版本,都引入了对策略更新幅度(保证了策略的稳定单调提升),只不过TRPO采用的是硬约束的形式,得使用二阶优化方法(比如共轭梯度),效率低,PPO将硬约束变成了软约束

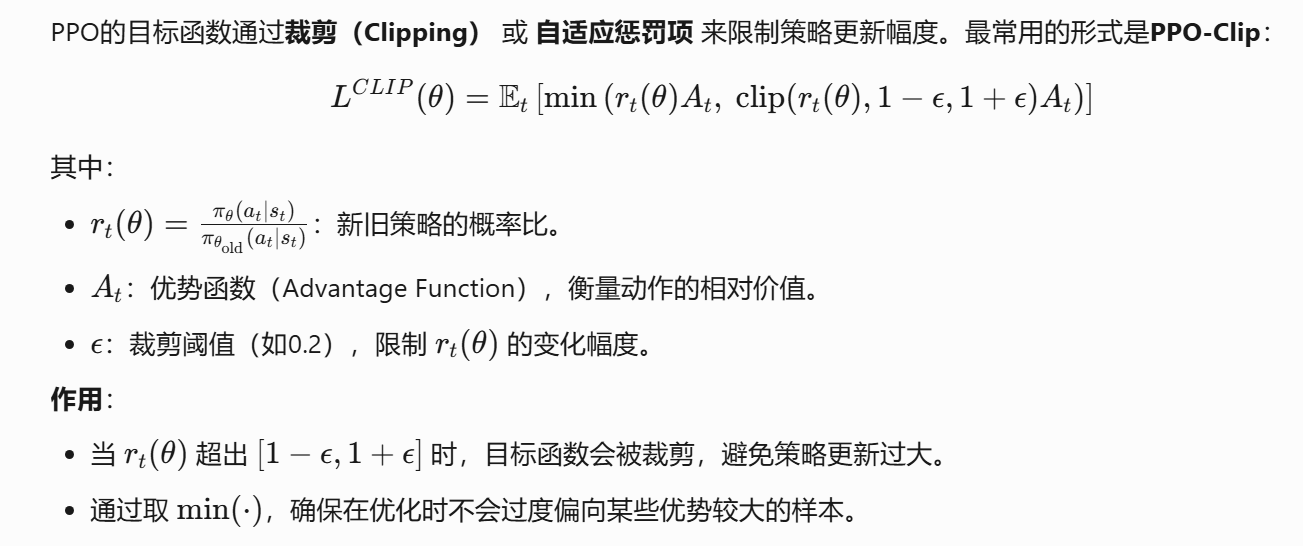

为了实现对策略更新幅度的软约束,ppo通常在目标函数里面剪切新旧策略的比率,或者引入KL散度,来限制策略的更新幅度

因为策略的更新幅度被限制,所以ppo弱化了on-policy和off-policy的概念,从理论上说,他是on-policy,但是因为更新幅度被限制,所以他能利用部分旧数据,在一定程度上来说也是off-policy

现在ppo通常使用GAE来估计优势函数,调节参数来平衡方差与偏差

Hi,早上好!欢迎来到Cxy的小破站!

© 2025 Candy的小破站